斯坦福大学机器学习第四课"多变量线性回归“学习笔记,本次课程主要包括7部分:

1) Multiple features(多维特征)

2) Gradient descent for multiple variables(梯度下降在多变量线性回归中的应用)

3) Gradient descent in practice I: Feature Scaling(梯度下降实践1:特征归一化)

4) Gradient descent in practice II: Learning rate(梯度下降实践2:步长的选择)

5) Features and polynomial regression(特征及多项式回归)

6) Normal equation(正规方程-区别于迭代方法的直接解法)

7) Normal equation and non-invertibility (optional)(正规方程在矩阵不可逆情况下的解决方法)

以下是每一部分的详细解读:

1) Multiple features(多维特征)

第二课中我们谈到的是单变量的情况,单个特征的训练样本,单个特征的表达式,总结起来如下图所示:

对于多维特征或多个变量而言:以房价预测为例,特征除了“房屋大小外”,还可以增加“房间数、楼层数、房龄”等特征,如下所示:

定义:

n = 特征数目

= 第i个训练样本的所有输入特征,可以认为是一组特征向量

= 第i个训练样本的所有输入特征,可以认为是一组特征向量

= 第i个训练样本第j个特征的值,可以认为是特征向量中的第j个值

= 第i个训练样本第j个特征的值,可以认为是特征向量中的第j个值

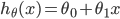

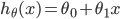

对于Hypothesis,不再是单个变量线性回归时的公式:

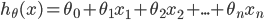

而是:

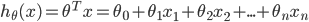

为了方便,记 = 1,则多变量线性回归可以记为:

= 1,则多变量线性回归可以记为:

其中 和x都是向量。

和x都是向量。

2) Gradient descent for multiple variables(梯度下降在多变量线性回归中的应用)

对于Hypothesis:

其中参数: ,

,  ,...,

,..., 可表示为n+1维的向量

可表示为n+1维的向量

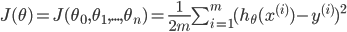

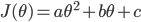

对于Cost Function:

梯度下降算法如下:

对 求导,分别对应的单变量和多变量梯度下降算法如下:

求导,分别对应的单变量和多变量梯度下降算法如下:

当特征数目为1,也就是n=1时:

当特征数目大于1也就是n>1时,梯度下降算法如下:

3) Gradient descent in practice I: Feature Scaling(梯度下降实践1:特征归一化)

核心思想:确保特征在相似的尺度里。

例如房价问题:

特征1:房屋的大小(0-2000);

特征2:房间数目(1-5);

简单的归一化,除以每组特征的最大值,则:

目标:使每一个特征值都近似的落在 的范围内。

的范围内。

举例:因为是近似落在这个范围内,所以只要接近的范围基本上都可以接受,例如:

0<=x1<=3, -2<=x2<=0.5, -3 to 3, -1/3 to 1/3 都ok;

但是:-100 to 100, -0.0001 to 0.0001不Ok。

Mean Normalization(均值归一化):

用 替换

替换 使特征的均值近似为0(但是不对

使特征的均值近似为0(但是不对 处理),均值归一化的公式是:

处理),均值归一化的公式是:

其中 可以是特征的取值范围(最大值-最小值),也可以是标准差(standard deviation).

可以是特征的取值范围(最大值-最小值),也可以是标准差(standard deviation).

对于房价问题中的两个特征,均值归一化的过程如下:

4) Gradient descent in practice II: Learning rate(梯度下降实践2:步长的选择)

对于梯度下降算法:

需要注意两点:

-"调试”:如何确保梯度下降算法正确的执行;

-如何选择正确的步长(learning rate):  ;

;

第二点很重要,它也是确保梯度下降收敛的关键点。要确保梯度下降算法正确运行,需要保证  在每一步迭代中都减小,如果某一步减少的值少于某个很小的值

在每一步迭代中都减小,如果某一步减少的值少于某个很小的值  , 则其收敛。例如:

, 则其收敛。例如:

如果梯度下降算法不能正常运行,考虑使用更小的步长 ,这里需要注意两点:

,这里需要注意两点:

1)对于足够小的 ,

,  能保证在每一步都减小;

能保证在每一步都减小;

2)但是如果 太小,梯度下降算法收敛的会很慢;

太小,梯度下降算法收敛的会很慢;

总结:

1)如果 太小,就会收敛很慢;

太小,就会收敛很慢;

2)如果 太大,就不能保证每一次迭代

太大,就不能保证每一次迭代 都减小,也就不能保证

都减小,也就不能保证 收敛;

收敛;

如何选择 -经验的方法:

-经验的方法:

..., 0.001, 0.003, 0.01, 0.03, 0.1, 0.3, 1...

约3倍于前一个数。

5) Features and polynomial regression(特征及多项式回归)

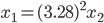

例子-房价预测问题:

特征 表示frontage(正面的宽度),特征

表示frontage(正面的宽度),特征 表示depth(深度)

表示depth(深度)

同时 也可以用一个特征表示:面积 Area = frontage * depth

也可以用一个特征表示:面积 Area = frontage * depth

即  , x表示面积。

, x表示面积。

多项式回归:

很多时候,线性回归不能很好的拟合给定的样本点,例如:

所以我们选择多项式回归:

对于特征的选择,除了n次方外,也可以开根号,事实上也是1/2次方:

6) Normal equation(正规方程-区别于迭代方法的直接解法)

相对于梯度下降方法,Normal Equation是用分析的方法直接解决 .

.

正规方程的背景:

在微积分里,对于1维的情况,如果 属于R:

属于R:

求其最小值的方法是令:

然后得到 .

.

同理,在多变量线性回归中,对于 ,Cost Function是:

,Cost Function是:

求取 的思路仍然是:

的思路仍然是:

对于有4组特征(m=4)的房价预测问题:

其中X 是m * (n+1)矩阵:

y是m维向量:

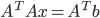

则Normal equation的公式为:

注:这里直接给出了正规方程的公式,没有给出为什么是这样的,如果想知道原因,建议看看MIT线性代数 第4章4.3节“最小二乘法”的相关内容,这里面最关键的一个点是:

“The partial derivatives of  are zero when

are zero when  .

.

举例可见官方的PPT,此处略;

Octave公式非常简洁:pinv(X' * X) * X' * y

对于m个样本,n个特征的问题,以下是梯度下降和正规方程的优缺点:

梯度下降:

需要选择合适的learning rate  ;

;

需要很多轮迭代;

但是即使n很大的时候效果也很好;

Normal Equation:

不需要选择 ;

;

不需要迭代,一次搞定;

但是需要计算 ,其时间复杂度是

,其时间复杂度是

如果n很大,就非常慢

7) Normal equation and non-invertibility (optional)(正规方程在矩阵不可逆情况下的解决方法)

对于Normal Equation,如果 不可逆怎么办?

不可逆怎么办?

1) 去掉冗余的特征(线性相关):

例如以平方英尺为单位的面积x1, 和以平方米为单位的面积x2,其是线性相关的:

2) 过多的特征,例如m <= n:

删掉一些特征,或者使用regularization--之后的课程会专门介绍。

参考资料:

你好,我正在学习语音信号处理方面内容

感觉各种模型及算式不太理解,请教下这方面内容应如何掌握,是否需要别的预备知识

[回复]

52nlp 回复:

24 5 月, 2012 at 22:45

个人觉得,首先需掌握线性代数,微积分,概率统计的基本知识,这是真正理解这些模型的前提;

Coursera上的Andrew Ng机器学习课程对于上述数学要求不高,并且介绍了基本的线性代数知识,是机器学习很好的入门材料;

进一步的学习可以看看Andrew Ng在斯坦福大学的授课视频和相关材料,这个对数学有进一步的要求。

[回复]

xiangfan 回复:

9 7 月, 2015 at 23:46

我想请问下,入门的材料具体是那门课程???

[回复]

52nlp 回复:

10 7 月, 2015 at 08:40

就是这门课程 http://coursegraph.com/coursera_ml

hi

想问下梯度下降的那个公式里,为什么梯度求和以后还要除以一个样本数m? 不理解这么做的意义何在。 但是好像如果样本非常之多不除这个数的话,求和后的梯度会非常大, 会出来一个几乎不可理喻的权重值。 希望能解释下,谢谢。

[回复]

你好~~

本人对梯度下降法实践技巧1---特征归一化 表示不解。比如就两个变量来说,通过梯度归一化让J(θ)的曲线从椭圆形变成圆形 以加快它的收敛速度,为什么归一化后J(θ)的曲线的形状会变换成近似圆形?

[回复]

weidong.xue 回复:

26 6 月, 2015 at 19:29

归一化不是为了加快收敛速度,而是为了保证最终收敛到目标范围。如果是椭圆形,收敛过程中,θ很容易冲到目标值之外,尤其是步长给的大的时候。使用随机梯度下降之时,更容易出现冲出的现象。

很明显,归一化后,因变量的大小类似,其系数的大小差一般都会在一个数量级,因此更圆。图中的园,只是一种比较理想的情况,解释用而已。

[回复]

想知道:笔记是怎么做的?

[回复]

LZ,好像有些课没有啊。比如第五课没有,第四课完了直接到第六课了。。。

[回复]

52nlp 回复:

4 8 月, 2015 at 15:26

第五课貌似只是““Octave Tutorial”,具体可以看一下“我爱公开课”上的索引:http://52opencourse.com/tag/%E6%9C%BA%E5%99%A8%E5%AD%A6%E4%B9%A0%E7%AC%94%E8%AE%B0

[回复]

谢谢分享

[回复]